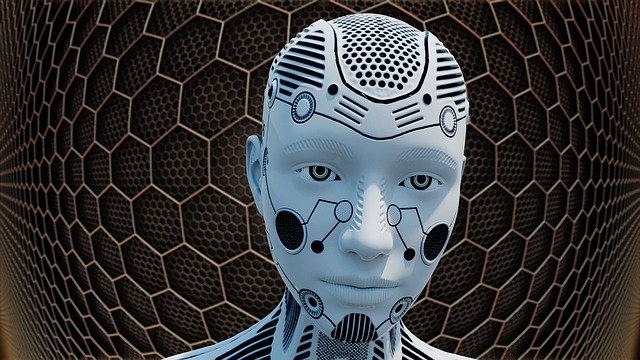

Как да се доверяваме на изкуствения интелект, когато не знаем какво мисли?

Бруталната истина да бъдеш човек е, че никога не можеш да узнаеш мислите на никой друг освен себе си. Единственото съзнание, до което имаме открит достъп, е нашето собствено и всичко, което знаем за другите, включително най-близките и най-скъпите ни, е това, което можем, спекулативно да заключим от техните думи и действия или от това, което решат да разкрият чрез обяснение.

И така, в свят, все по-населен от нечовешки агенти, като роботи и изкуствен интелект, непознаваемостта на ума се трансформира в нов тип тревожност. Въпреки че можем да заключим, че мисловните процеси и мотивациите на другите трябва да се съгласуват до голяма степен с нашите собствени благодарение на нашата споделена биология, няма такова умствено сближаване с машините.

Как можем да се доверим на изкуствения интелект (AI), ако не знаем какво мисли?

Тази тревожност е била източник на вдъхновение за редица писатели на научна фантастика през годините. Това е литература на промяната за обществата наситени с технологии и често ни помага да изследваме продължаващия процес на взаимна трансформация. Докато развиваме и усъвършенстваме технологията, тя започва да предефинира нашия начин на живот и мислене, което от своя страна поражда нови технологични желания.

Както се аргументира американският литературен критик Фредерик Джеймсън, функцията на научната фантастика е „да не ни дава„ образи “на бъдещето…, а по-скоро да променя и преструктурира нашия опит от настоящето.“

Още от първите дни на научната фантастика мотивациите и причините, които стоят зад действието на роботите, са източник на несигурност. Айзък Азимов в много от своите кратки разкази изследва обяснения за поведението на машината, често донякъде песимистично. Важен фокус на подобни истории е идеята, че самите роботи могат да дадат на хората обяснение за своето мислене и поведение. Тези обяснения са жизненоважни за насърчаване на доверието.

Пример за връзката между машинните обяснения и човешкото доверие е даден от Робин Р Мърфи от Тексаския университет A&M в неотдавнашна статия в списание Science Robotics. Тя посочва история от 1972 г., наречена Long Shot от плодовития американски писател на научна фантастика Вернор Винг.

В историята космическият кораб на пръв поглед изглежда нелоялен, като се отклонява от установения план на полета, само за да обясни по-късно, че поради чувствителна към времето ситуация, корабът не успява да се консултира първо с човешките надзорници. При този сценарий недоверието се разсейва от робота, който е в състояние да обясни действията си.

Както често се случва, връзката между научната фантастика и науката е дълбока. Също така в Science Robotics, екип от международни изследователи на изкуствения интелект, ръководен от Дейвид Ганинг от Агенцията за напреднали научни проекти в областта на отбраната на САЩ (DARPA), предлага ясен отчет за това, което е известно в настоящите изследвания на AI, като „обясним изкуствен интелект“ или XAI.

Според авторите „XAI система трябва да може да обясни своите възможности и разбирания; да обясни какво е направила, какво прави сега и какво ще се случи след това; както и да разкрие важната информация, въз основа на която действа.“

Това е особено важно сега, тъй като голяма част от поведението на ИИ се основава на начина, по който машините се учат, а машинното обучение често е труден и непрозрачен процес. Целта на XAI, пишат авторите е, че в свят, пълен с ИИ, „обясненията са от съществено значение потребителите да разберат, да се доверят и ефективно да управляват тези нови, изкуствено интелигентни партньори.“

Интересното е, че Ганинг и колегите му посочват като проблем това, че най-ефективните методи, чрез които машините учат, често са най-малко обясними, а най-обяснимите елементи на машинното вземане на решения често са най-малко точните.

Това води до голямо изследване по темата на XAI в неотдавнашния брой на Science Robotics, по който както Мърфи, така и екипът на Ганинг дебатират.

Американски изследователи, водени от Марк Едмондс, Фън Гао и техни колеги от Калифорнийския университет в Лос Анджелис, отчитат заключенията от своето експериментално проучване на начина, по който да се повиши доверието на хората към роботите и изкуствения интелект.

XAI е в начален стадий на развитие, тъй като повечето изследователи са по-фокусирани върху изпълнението на задачите поставени на AI, отколкото върху получаването на обяснение за това изпълнение. Това е възпрепятствано и от различните нива на обяснителност по отношение на различните стратегии за машинно обучение, от които има два основни примера: символичен анализ на задачи, като дърво за решения, и машинно обучение въз основа на дълбоки невронни мрежи.

Статия от Стефан Флайшфресер (Stephen Fleischfresser), публикувана в списание Cosmos.